ทำไม GPT เขียนดีกว่าพนักงานบางคน!! (นี่แค่จุดเริ่มต้นเท่านั้น)

บทความอ้างอิงจาก หลักสูตร "Generative AI for Beginners" ของ Carlos de Castelluccio

ผู้เชี่ยวชาญ AI จาก Microsoft

Timeline 4 ยุคของ AI : จาก "หุ่นยนต์ท่องจำ" สู่ "นักเขียนมือรางวัล"

1 ยุค Rule-based (1950-1960): AI แบบตำราเรียน

กลไกที่มนุษย์ป้อน : ตอบตามกฎ "ถ้า...แล้ว..."

ตัวอย่าง:

คุณ: "อยากทราบรายละเอียดสินค้า"

ระบบ: "กรุณากด 1 เพื่อฟังข้อมูล" (หากไม่กดเลข ไม่ตอบ)

❌ จุดอ่อน: ถามนอกคำสั่ง ..กริบ !!

2 ยุค Machine Learning (1990): AI เริ่มเรียนเก่ง

พัฒนาการ: ใช้สถิติเดาความสัมพันธ์ระหว่างคำ

ตัวอย่าง: ระบบแปลภาษาอัตโนมัติรุ่นแรก แปล "Good morning" เป็น "อรุณสวัสดิ์" ได้ แต่พลิกประโยคซับซ้อนไม่ได้

3 ยุค Neural Networks (2000s): AI มีเซลล์ประสาทเทียม

จุดเปลี่ยน:

📱 Siri และ Google Assistant กำเนิด

🌐 Google Translate เริ่มแปลทั้งประโยคได้

ตัวอย่างไทย: แปล "สวัสดีครับ" เป็น "Hello" แทน "Sawatdee krub"

4 ยุค Transformer (2017-ปัจจุบัน): กำเนิด "GPT" นักเขียนอัจฉริยะ

เทคโนโลยี: กลไก Attention (สมองกลที่โฟกัสได้หลายจุดพร้อมกัน)

ตัวอย่าง:

ChatGPT เขียนเรียงความได้ใน 1 นาที

DALL-E สร้างภาพ "พญานาค กับ หุ่นยนต์"

รู้จัก GPT

GPT ย่อมาจาก: Generative (สร้างเนื้อหาใหม่) + Pre-trained (ฝึกมาก่อน) + Transformer (โครงสร้างสมองกล)

GPT ทำงานยังไง?

แปลงคำเป็นตัวเลข (Tokenization)

"ครูชอบสอนAI" → ["ครู", "ชอบ", "สอน", "AI"] → [1024, 5678, 8910, 9999]

เดาคำถัดไป (Next Token Prediction)

"พระนเรศวร______" → "ทรงประกาศอิสรภาพ"

เพิ่มความสุ่มสร้างสรรค์ (Temperature)

0 = ตอบซ้ำเดิมเป๊ะ

1 = สร้างเมนูอาหารจากวัตถุดิบแปลกๆ

กลไกการทำงานของTransformer และ Tokenization

1 Tokenization คืออะไร

คือการแยกประโยคหรือข้อความออกเป็น “โทเค็น” (คำ หรือส่วนของคำ)

ตัวอย่างภาษาไทยที่ชัดเจน:

ประโยค: “วันนี้อากาศดีมาก”

อาจถูกแยกเป็น: [“วัน”, “นี้”, “อากาศ”, “ดี”, “มาก”] หรือ [“วันนี้”, “อากาศ”, “ดี”, “มาก”] แล้วแต่ระบบ

2 การทำนายโทเค็นถัดไป (Next Token Prediction)

โมเดลนำบริบทที่มีอยู่มาทำนายคำถัดไป

ตัวอย่างชัดเจนภาษาไทย:

เริ่ม: “พระบาทสมเด็จพระนารายณ์มหาราช”

ทำนายใหม่: “ทรง” → “พระบาทสมเด็จพระนารายณ์มหาราชทรง”

ทำนายใหม่: “มี” → “พระบาทสมเด็จพระนารายณ์มหาราชทรงมี”

ดำเนินต่อไปเรื่อย ๆ

3 ความคิดสร้างสรรค์มาจากไหน?

โมเดลไม่ได้เลือกโทเค็นที่มีความน่าจะเป็นสูงสุดเสมอไป

ใช้กลไกสุ่ม (Temperature) ทำให้ได้คำตอบที่หลากหลายและสร้างสรรค์

ตัวอย่างชัดเจน:

ขอ “บทกวีทะเล” 10 ครั้ง จะได้บทกวี 10 แบบ ไม่ซ้ำกันเลย

ประเภทของPrompt และตัวอย่างที่ชัดเจน

Instruction Prompt (คำสั่ง)

“เขียนแผนการสอนเรื่องกฎของนิวตัน สำหรับนักเรียน ม.3” AI จะสร้างแผนการสอนละเอียดครบถ้วน

Question Prompt (คำถาม)

“ทำไมสมเด็จพระนเรศวรมหาราชจึงประกาศอิสรภาพ?” AI จะอธิบายประวัติศาสตร์ได้ชัดเจน

Completion Prompt (เติมข้อความที่ไม่สมบูรณ์)

“สัตว์ที่พบในป่าชายเลน ได้แก่…” AI จะเติมข้อความ เช่น ปูก้ามดาบ ปลาตีน นกยางเปีย ฯลฯ

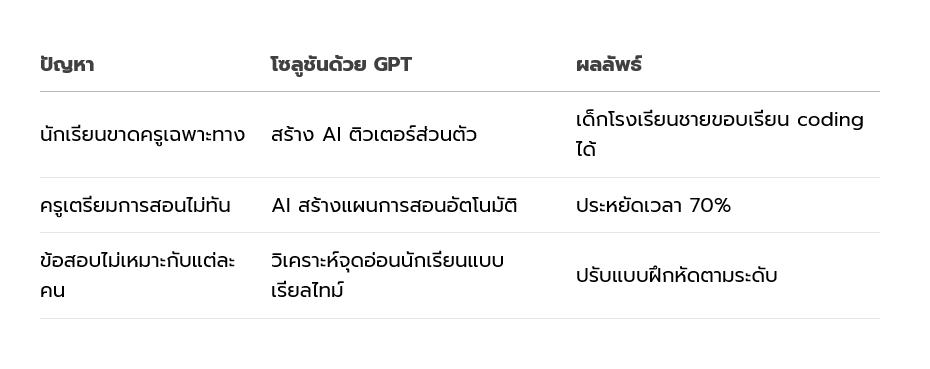

อนาคตอันใกล้ เมื่อAI กลายเป็น "ครูคนที่สอง"

ข้อควรรู้ก่อนใช้ Generative AI

1 อย่าเชื่อทุกคำตอบ:

AI อาจ "เพ้อ" (Hallucination) เช่น บอกว่า "พระนเรศวรทรงใช้ ทวิตเตอร์ สื่อสาร"

2 ปรับระดับความสร้างสรรค์:

ใช้ Temperature คุมการสุ่ม เหมือนปรับไฟเตาแก๊ส

ต้องการความแม่นยำสูง: ใช้ Temperature=0.0 เช่น คำนวนสูตรเคมี

สร้างไอเดียแปลกใหม่: ใช้ Temperature=0.9 เช่น ตั้งชื่อแบรนด์

เขียนบทสนทนาตลก: ใช้ Temperature=0.75 เช่น สคริปต์ซีรีส์คอมเมดี้

แปลภาษา: ใช้ Temperature=0.3 เพื่อป้องกันการเพี้ยนความหมาย

แต่งเพลง: ใช้ Temperature=1.0 ให้ได้คำคล้องจองไม่ซ้ำใคร

3 ตรวจสอบ bias:

AI อาจมีอคติจากข้อมูลฝึก เช่น เชื่อว่า "ผู้จัดการต้องเป็นผู้ชาย"

#อ่านพอรู้ที่มา … บทความต่อไป @underdog จะย่อยหลักการ prompt ให้เข้าใจแบบง่ายที่สุด

(เครดิต: หลักสูตร "Generative AI for Beginners" โดย Microsoft, งานวิจัย "Attention is All You Need" (2017))

รุ่งพร มีศิลป์ - บทความ

เจติยา เฉยรอด - ภาพประกอบ