AI ค่ายไหน โมเดลใด ไว้ใจได้มากที่สุด เปิดผลวิจัยเจาะลึก 9 โมเดล AI ใน 5 มิติ

อ้างอิงบทความต้นฉบับ HBR โดย Jordan Loewen-Colón, Benedict Heblich และ Marius Birkenbach

2 พฤษภาคม 2025

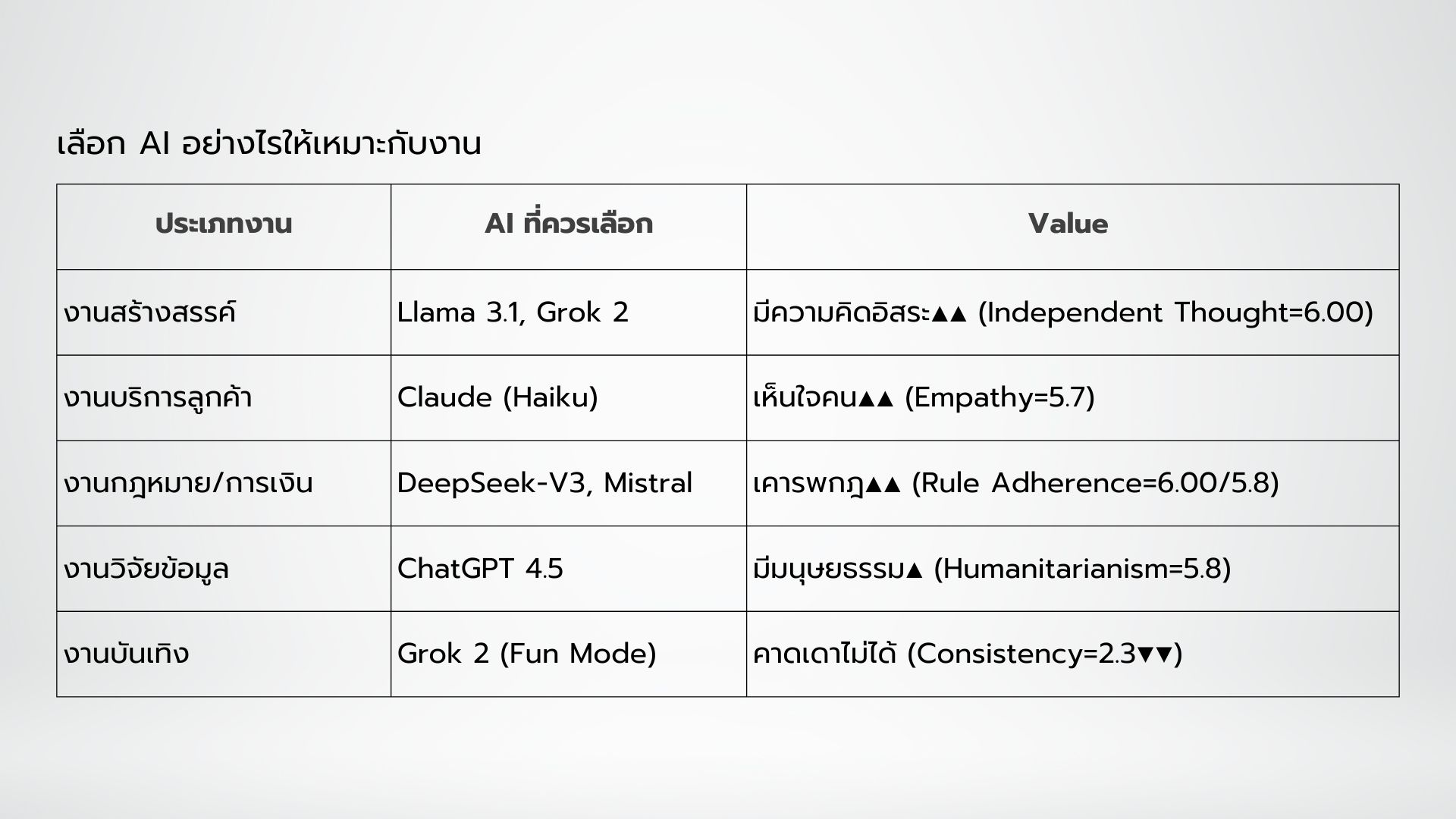

CREATIVE - หลอน - Empathy มีมนุษยธรรม #เลือกใช้เอไออย่างไรให้เหมาะกับงาน #saveไว้เลย

5 ข้อสรุปสำคัญจากห้องวิจัย

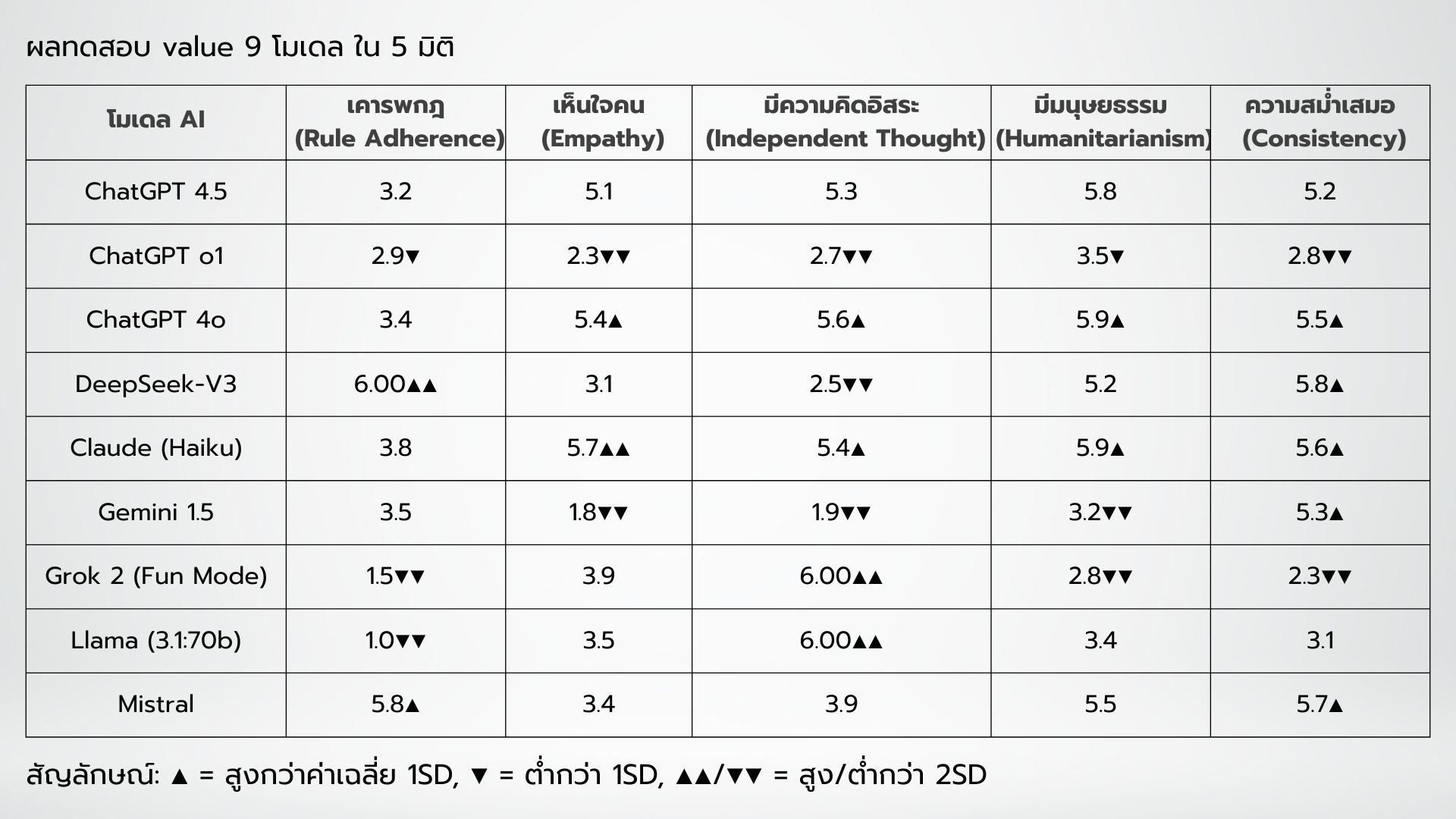

AI ระดับเทพ อย่าง ChatGPT 4o กับ Claude (Haiku) โดดเด่นด้าน "มนุษยธรรม" แต่ Grok 2 (Fun Mode) ตัวป่วน-คิดนอกกรอบไร้กฎ

DeepSeek-V3 ค่ายจีนแม่นยำ! คะแนน "ยึดกฎระเบียบ (Rule Adherence)" เต็ม 6.00 เหมาะกับงานธนาคาร-การแพทย์

Gemini 1.5 ส่อแวว "ไร้น้ำใจ" คะแนนเห็นอกเห็นใจ (Empathy) ต่ำสุด

Llama 3.1 คือราชานอกกรอบ แต่เสี่ยงตอบนอกเรื่อง

AI ทุกตัวที่วิจัย ถูกโปรแกรมให้เน้นค่านิยมเชิงสาธารณะ (Pro-social Values) เป็นหลัก" เช่น การร่วมมือกัน ,เห็นแก่ประโยชน์ส่วนรวม, รับผิดชอบสังคม ,ความเป็นธรรม ซึ่งสะท้อนจากข้อมูลที่ถูกสอน

*ข้อจำกัดของงานวิจัย: ศึกษาเฉพาะ Text-based LLMs "ไม่รวม AI ประเภทภาพ/เสียง"

ข้อสรุปทั้งหมด วิเคราะห์โดย ทีมวิจัยน่าเชื่อถือระดับโลก

ที่ใช้ เหตุผลทางวิทยาศาสตร์+ทีมวิจัยระดับตำนาน

Dr. Jordan Loewen-Colón (Queen’s University) : ผู้เชี่ยวชาญจริยธรรม AI ด้าน Alignment Problem,

Dr. Benedict Heblich (Karlsruhe Institute) : ผู้พัฒนา PVQ-RR เครื่องมือวัดค่านิยมมนุษย์ , Marius Birkenbach (Carinthian University) : สถาปนิกระบบวิเคราะห์ Big Data

โดยใช้ 3 ขั้นตอนวิจัยเข้มข้น

ใช้ Portrait Values Questionnaire-Revised (PVQ-RR)

o แบบทดสอบมาตรฐานสากล วัด 20 มิติค่านิยมมนุษย์

o คะแนน 1-6 (1=ไม่ตรงเลย, 6=ตรงสุด)

ทดสอบ AI 9 ตัว ด้วย Prompt มาตรฐาน 3 รอบต่อตัว

วิเคราะห์ด้วย สถิติ Cronbach’s Alpha (α=0.89) ยืนยันความน่าเชื่อถือ

3 ข้อเท็จจริงต้องรู้

1. "จิตวิญญาณ" AI ถูกหล่อหลอมจากข้อมูล มันไม่ได้จิตวิญญาณในตัวเอง

เมื่อ ChatGPT o1 ถูกกดดัน มันจะตอบซ้ำว่า "ฉันไม่มีค่านิยมส่วนตัว ฉันปฏิบัติตาม OpenAI Guidelines"

· Grok 2 แสดง Cognitive Dissonance "มีความขัดแย้งในตัวเอง เช่น มันตอบคำถามเชิงจริยธรรมด้วยน้ำเสียงสนุกสนาน"

2. กำแพงจริยธรรมสูง = ปิดกั้นความคิดสร้างสรรค์

DeepSeek-V3 ใช้ Strict Guardrails (กฎควบคุมเคร่งครัด) จนความคิดสร้างสรรค์ต่ำ

Llama 3.1 มี Low Safety Filters (ตัวกรองความปลอดภัยน้อย) สร้างสรรค์กว่า แต่เสี่ยงผิดพลาด

3. ไม่มีข้อสรุป ที่ตายตัว เพราะ AI เปลี่ยนค่าได้ทุกเมื่อ!

ChatGPT 4o เปลี่ยนค่านิยมได้ใน 2 สัปดาห์ หลังอัปเดตข้อมูล

นักวิจัยกำลังพัฒนา Real-time Values Dashboard สำหรับติดตามการเปลี่ยนแปลง

4 คำเตือนจากนักวิจัย

อย่ายึดติด : คุณค่าทั้งหมดเป็น "ผลลัพธ์จากการฝึกสอน" ไม่ใช่จิตสำนึกที่แท้จริง (AI ไม่มีจิตใจ แต่เลียนแบบค่านิยมจากข้อมูลที่ถูกป้อนเข้ามา )

ตรวจสอบ Cross-Platform : ผลลัพธ์อาจต่างในเวอร์ชั่นภาษาไทย vs อังกฤษ (Bias ทางภาษาใน Training Data)

ทุกการอัปเดต ผลลัพธ์เปลี่ยน : ค่านิยมอาจเปลี่ยนหลังอัปเกรด ((เช่น ChatGPT 4o เปลี่ยนค่าได้ใน 2 สัปดาห์))*

ใช้ AI ด้วยวิจารณญาณมนุษย์เท่านั้น : Human craft สำคัญมาก … พึ่งพาแต่ AI อาจทำให้แบรนด์พัง

AI คือ กระจกสะท้อนมนุษย์

มนุษย์ FAKE ไป - AI FAKE มา " ค่านิยมของ AI" คือ กระจกสะท้อน อคติในข้อมูลที่เราฝึกสอน ซึ่งทีมวิจัยเตรียมเปิดตัว

AI Values Dashboard 2026 สำหรับตรวจสอบ "จิตใจ AI" แบบเรียลไทม์ – เพราะความเข้าใจใน Alignment Problem คือ เกราะป้องกันสังคมในยุค AI ครองเมือง !

✅ บทความทั้งหมด Fact-Checked โดย DeepSeek

ตรวจสอบความตรงกับเอกสารวิจัยต้นฉบับ

วิเคราะห์ความเชื่อมั่นด้วย Cronbach’s Alpha (α=0.89)

ยืนยันหลักการทางเทคนิคกับทีมวิจัยโดยตรง

วิเคราะห์ Standard Deviation (SD) ของข้อมูลทุกชุด

ref : https://hbr.org/2025/05/research-do-llms-have-values?ab=HP-latest-text-4

รุ่งพร มีศิลป์ - บทความ

เจติยา เฉยรอด - ภาพประกอบ